Tres econometristas salieron de cacería y se encontraron con un venado. El primero disparó, pero el tiro falló por un metro a la derecha. El segundo econometrista disparó, pero falló por un metro a la izquierda. El tercer econometrista no disparó, pero gritó triunfante: “¡Le dimos! ¡Le dimos!” (Chiste famoso de economistas de autor anónimo)

¡Hola!

Te doy la bienvenida al segundo post de esta serie sobre la revolución de la credibilidad. Es una serie que se encadena con varias relacionadas al método de Diferencias en Diferencias (DD).

Hoy hablaremos de la revolución de la credibilidad.

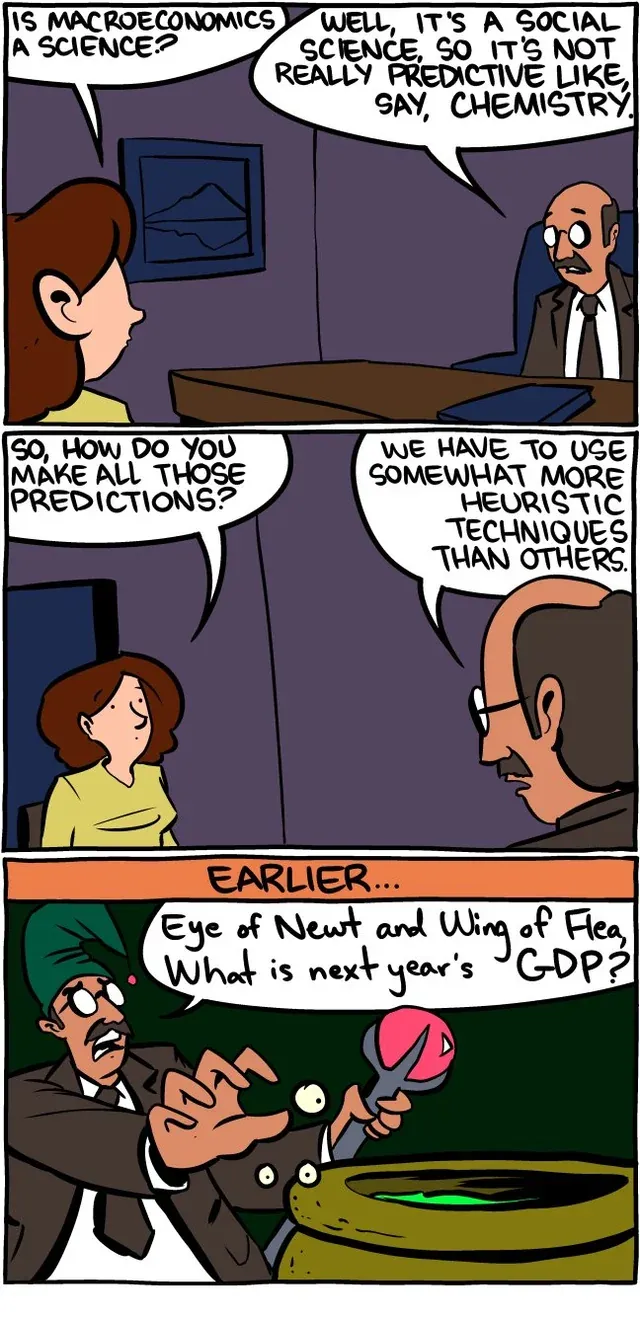

Los economistas recibimos por muchos años una muy mala fama. Hay un viejo chiste que dice que los economistas pasamos la mitad del año haciendo predicciones de lo que pasará y la otra mitad explicando por qué no pasó lo que dijimos. Pero en los años 90 y 2000s se presentó una revolución en la forma en que hacemos econometría.

La profesión cambió a los economistas de ser adivinos esotéricos a algo más parecido a la ciencia.

El éxodo de Cuba, los modelos micro de oferta y demanda de trabajo y el experimento natural de migración más grande del mundo

El 20 de abril de 1980, Fidel Castro, el entonces presidente de Cuba, anunció que abriría el puerto de Mariel para que se fueran de la isla todos aquellos que desearan irse con lo que pudieran cargar consigo.

Desde 1958, los Estados Unidos tienen un embargo contra Cuba que no permite a los negocios estadounidenses hacer ningún tipo de negocios con la isla. La economía de Cuba ha permanecido notablemente estancada por ya muchos años y muchas personas buscaban una oportunidad de hacerse de una mejor vida. En ese entonces el presidente era Fidel Castro, y no le gustó ni un poco.

De la noche a la mañana, la fuerza de trabajo de Miami creció un 7%.

Y estoy contando la fuerza total de trabajo. La mayoría de los que migraron de Cuba a Miami en ese barco llegaron a ocupar trabajos que no requieren educación superior, por lo que ese mercado de trabajo en particular creció mucho más.

De acuerdo al modelo que nos enseñaron en microeconomía, en el mercado laboral la oferta son los trabajadores y la demanda son las empresas buscando quién les provea del trabajo que necesitan para sus actividades. En este modelo, un aumento de la oferta de trabajadores implicaría que el “precio de equilibrio” del modelo (los salarios) tendrían que bajar. Y eso es justamente lo que los investigadores de la época pensaban que debería pasar (e.g. Borjas, 1986).

Pero el caso del éxodo de Mariel fue un experimento natural que David Card (1990) supo aprovechar.

- El shock en el mercado laboral del Miami fue exógeno. Entre Mayo y Septiembre de 1980 llegaron unos 125,000 cubanos de manera inesperada. Cuando hay shock externo y que no es generado por la misma dinámica de la región, se dice que es exógeno.

- El impacto fue mayormente local en Miami. Lo que permitió hacer una comparación clara con otras regiones cercanas con características similares.

Lo que encontraron fue que ese gran flujo de migrantes básicamente no tuvo ningún efecto en los salarios o en las tasas de desempleo de los trabajadores similares, incluyendo a los migrantes cubanos que habían llegado antes.

Hay dos razones de que no se haya encontrado ningún efecto:

- Al mismo tiempo de que se incrementó la oferta de trabajadores, se aumenta la demanda de trabajo. Los migrantes también son consumidores. Desde el primer momento en el que llegan a una región, comienzan a comer, a cortarse el pelo y a requerir medicinas y cuidados.

- Ya existía una comunidad cubana en Miami a la que los migrantes pudieron acudir y que les facilitaron el acceso al mercado. Desde dos décadas antes, Miami había estado recibiendo migración cubana, que le permitió a ese flujo a adaptarse rápidamente al mercado.

Este es un newsletter que trata de ciencia económica. En particular: econometría.

La econometría no es lo mismo que la ciencia de datos: es un área especial especializada en los datos económicos. Yo soy de la idea de que si eres economista, vale mucho la pena que aprendas a fondo la econometría y que te posiciones como econometrista, no como data scientist.

En los últimos años la econometría ha evolucionado y dejó de ser las recetas de cocina de los libros de texto de los 80s y se convirtió en un área completa de estudio con sus técnicas de inferencia causal propias. La diferencia está en el enfoque, que plantea pensar en experimentos y de ahí crear la estrategia de identificación.

En esta serie estaremos hablando de esta revolución de la credibilidad, incluyendo cómo evitar el sesgo de selección y cómo encontrar experimentos naturales. Es la primera serie que nos llevará a profundizar en el modelo de diferencias en diferencias, que es uno de los modelos de más crecimiento en los últimos años.

Su popularidad ha crecido mucho porque permite tener estudios con mucho valor y muchas credibilidad (sin tanto presupuesto).

Así que, si es de tu interés aprender esta técnica, te veo en el resto de las publicaciones de esta serie.

PS: Algunas de estas publicaciones estarán detrás de un muro de apago, pero te dejé un periodo de prueba de 7 días para que puedas verlas.

El día que la econometría dejó de ser una estafa

El estudio de David Card sobre el flujo migratorio de Miami fue un parteaguas en la forma de ver el mercado laboral, pero también en la forma de usar los experimentos naturales para identificar causas y efectos.

No fue el único. En 1983, Edward Leamer escribió un ensayo con el título provocador “Let’s take the con out of econometrics”. Se trata de un juego de palabras, porque no se puede escribir econometría en inglés sin incluir la palabra “con” (estafa). Es en realidad una discusión técnica sobre la forma en que los economistas usan los datos para darle soporte a cualquier tipo de argumento. Más aún, es en este artículo donde encontramos el origen de la idea de que el diseño de nuestros estudios deben tomar como base los experimentos, con un énfasis especial en los ensayos aleatorios.

Esta perspectiva se adoptó más fuerte en los 90s y 2000. Angrist & Pischke (2010) discuten las diferentes razones por las que los economistas comenzaron a desarrollar modelos más creíbles:

- Más y mejores fuentes de datos. En 1975, Isaac Ehrlicht publicó un artículo sobre el efecto disuasivo de la pena capital con una serie de tiempo anual de 35 observaciones que en nuestras épocas no podría ser publicado por falta de rigor. En la actualidad, el acceso a la información no es el problema. Si acaso nuestro mayor obstáculo hoy en día es saber distinguir entre las buenas fuentes y el trabajo de limpieza que tenemos que realizar.

- Mejores diseños de la investigación. Los métodos de variables instrumentales, regresión discontinua y diferencias en diferencias no son realmente nuevos, simplemente se están usando mejor y de manera más transparente. El estándar de los modelos está cambiando. Ya no es posible simplemente invocar una ecuación y asumir con una serie de pruebas que los supuestos son correctos de forma mecánica. Si la cosa fuera así, la inteligencia artificial ya habría acabado con nuestro trabajo.

- Mejor capacidad de cómputo. En 1965, Gordon Moore (fundador de Intel) hizo la observación de que el número de componentes por circuito integrado se duplicaba cada año e hizo la predicción de que esta tendencia continuaría al menos otra década (Moore, 1965). La sorpresa es que esa tendencia continuó muchos años después y a la fecha, todos nosotros tenemos en nuestro bolsillo computadoras que son más poderosas que las que llevaron a las personas a la luna.

Si hemos de buscar un origen a la llamada revolución de la credibilidad, podemos apuntar al trabajo de Lalonde (1986), que hizo una comparación de los resultados de una evaluación econométrica de un programa experimental de empleo subsidiado con un ensayo aleatorizado. Estudios posteriores ayudaron a establecer a los ensayos aleatorizados como la forma correcta de proceder, siempre que sea posible.

¿Y por qué seguir insistiendo en la inferencia causal y no en métodos más computacionalmente exhaustivos?

En 2008, Chris Anderson escribió en Wired que el método científico había quedado obsoleto.

En un ataque de tecno-optimismo típico de la era, Anderson observaba que los modelos de Machine Learning que estaban detrás de Google no tenían idea de por qué obteníamos los resultados que nos daba el algoritmo. Lo importante era que funcionaban. Frente al uso masivo de datos, el modelo de hacer hipótesis, modelar y hacer pruebas, quedaba obsoleto. Sólo necesitas alimentar al modelo con cantidades gigantes de datos y obtendrás los resultados que deseas.

Dos décadas después, aquí sigue el método científico y personas como yo aún tenemos trabajo.

Un problema de esta idea es que los objetivos que queremos optimizar suelen ser sensibles a nuestros sesgos. Peor aún, es posible obtener muchos diferentes resultados “significativos” haciendo modelos con una cantidad grande de variables. Así lo demostró Sala-i-Martin (1997) que literalmente ejecutó dos millones de regresiones relacionadas al crecimiento económico(y así le puso de título al paper).

Tomó 62 variables explicativas, dejó 3 variables como control fijo (PIB, esperanza de via y la tasa de inscripción a escuela primaria en 1960) y dejó las otras 59 variables como “regresores de interés”. De esos 59, eligió conjuntos de 3 controles adicionales hasta que cada una de las variables juega el rol de “variable de interés”. Al final, cada regresor de interés generaba 30,857 regresiones.

¿Te das cuenta? Tú y yo podríamos estar eligiendo nuestras regresiones igual y obtener resultados significativos simplemente por suerte y no porque sea un buen diseño.

Referencias

Anderson, C. (2008, junio 10). The End of Theory: The Data Deluge Makes the Scientific Method Obsolete. Wired. https://www.wired.com/2008/06/pb-theory/

Angrist, J. D., & Pischke, J.-S. (2010). The credibility revolution in empirical economics: How better research design is taking the con out of econometrics. Journal of Economic Perspectives, 24(2), 3–30

Borjas, G. J. (1986). Immigrants, minorities, and labor market competition (Working Paper No. 2028). National Bureau of Economic Research. https://www.nber.org/papers/w2028

Card, D. (1990). The impact of the Mariel boatlift on the Miami labor market. ILR Review, 43(2), 245–257. https://doi.org/10.1177/001979399004300205

Ehrlich, I. (1975). The deterrent effect of capital punishment: A question of life and death. American Economic Review, 65(3), 397–417.2

LaLonde, R. J. (1986). Evaluating the econometric evaluations of training programs with experimental data. The American Economic Review, 76(4), 604–620.

Leamer, E. E. (1983). Let's take the con out of econometrics. The American Economic Review, 73(1), 31–43

Moore, G. E. (1965, April 19). Cramming more components onto integrated circuits. Electronics, 38(8), 114–117. http://cva.stanford.edu/classes/cs99s/papers/moore-crammingmorecomponents.pdf

Sala-I-Martin, X. (1997). I just ran two million regressions. The American Economic Review, 87(2), 178–183.